隨著大數據技術的飛速發展,高效的數據存儲與處理成為關鍵。不同的文件格式和數據處理服務,共同構成了大數據生態系統的基石。本文將介紹幾種常用的大數據文件格式,并概述主流的數據處理與存儲支持服務。

一、 常用大數據文件格式

- 文本格式

- CSV/TSV:以逗號或制表符分隔的純文本文件,結構簡單,兼容性極強,是人類可讀的格式。但其缺乏模式定義,解析效率較低,且不支持復雜數據類型,通常用于數據交換或臨時存儲。

- JSON:基于JavaScript的輕量級數據交換格式,采用鍵值對結構,支持嵌套和復雜數據類型,具有良好的可讀性。由于其解析成本較高且存儲冗余,常用于Web API和半結構化數據存儲。

- 行列存儲格式

- Apache Parquet:一種面向列的存儲格式,專為高效查詢和處理大規模數據集而設計。它提供了高效的壓縮和編碼方案,能顯著減少I/O操作,特別適合執行聚合查詢的OLAP場景,是Hadoop/Spark生態系統的首選列式格式。

- Apache ORC:另一種高效的列式存儲格式,最初為Hive設計。它在壓縮率、讀寫性能和ACID事務支持方面表現優異,特別適合Hive數據倉庫。

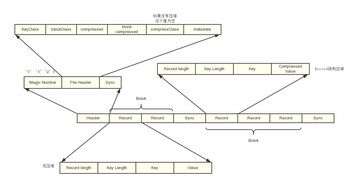

- Apache Avro:一種基于行的數據序列化系統,強調數據交換。它使用JSON定義模式,將模式與數據一同存儲,支持動態模式演化,非常適合RPC和數據流場景。

- 其他優化格式

- Apache Arrow:并非一種持久化存儲格式,而是一種內存中的列式數據格式標準,旨在實現不同系統間零拷貝的高性能數據交換,極大提升了內存計算效率。

選擇哪種格式,取決于具體場景:列式格式(如Parquet)適合分析查詢;行式格式(如Avro)適合需要訪問整條記錄的流處理;文本格式(如JSON)則更適合數據交換和靈活模式。

二、 數據處理與存儲支持服務

數據處理與存儲并非孤立存在,它們依賴于強大的底層服務。這些服務主要分為兩大類:

1. 分布式存儲服務

這些服務提供了可靠、可擴展的底層存儲,是數據湖或數據倉庫的基石。

- Hadoop Distributed File System:經典的分布式文件系統,具有高容錯性,能以流式訪問超大規模數據集,是早期大數據生態的核心存儲。

- 云對象存儲服務:如Amazon S3、阿里云OSS、騰訊云COS等。它們提供了近乎無限的存儲空間、高持久性和按需付費模式,已成為現代數據湖架構的事實標準存儲層,可與各類計算引擎無縫集成。

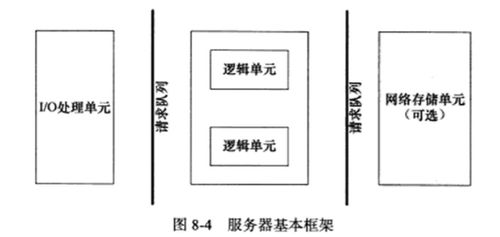

2. 數據處理與計算服務

這些服務在存儲層之上,提供數據的計算、加工和分析能力。

- 批處理框架:以Apache Spark為代表,支持內存計算,能夠高速處理海量數據的ETL、批分析和機器學習任務。Apache Flink同樣強大,并以其流批一體的架構著稱。

- 查詢引擎:如Presto/Trino、Apache Hive,它們允許用戶使用SQL或類SQL語言直接對存儲在HDFS或對象存儲中的大規模數據進行交互式查詢。

- 流處理服務:專為處理無界數據流設計,如Apache Kafka(消息隊列,常作為流數據管道)、Apache Flink和Apache Storm,能實現低延遲的實時數據處理。

- 托管服務:云廠商提供了全托管的服務以簡化運維,例如Amazon EMR、阿里云EMR(托管Hadoop/Spark集群)、Google BigQuery(無服務器數倉)、Snowflake(云原生數倉)等。這些服務將計算與存儲分離,提供了極佳的彈性和易用性。

三、 與趨勢

在現代大數據架構中,云對象存儲常作為統一的數據湖存儲層,存儲著Parquet、ORC等格式的原始或加工后的數據。Spark、Flink等計算框架則從存儲中讀取數據進行處理,處理結果再寫回存儲。Presto等查詢引擎可對這些結果進行即席分析。整個過程由Kafka等流處理組件保障實時性,并由云上的托管服務簡化管理。

未來的趨勢是存儲與計算的進一步分離、格式的持續優化(如更好地支持謂詞下推和壓縮),以及數據處理服務向無服務器化、智能化和實時化演進,使得企業能夠更敏捷、更經濟地從海量數據中提取價值。