Kafka作為高吞吐量的分布式消息系統,通過多重機制保障數據的完整性和可靠性。本文將從消息防丟失、消費模式、存儲形式及支撐服務四個維度展開詳細解析。

一、Kafka如何保證消息不丟失

- 生產者端保障機制

- 異步發送模式下啟用回調確認

- 同步發送模式設置acks=all/-1(需所有ISR副本確認)

- 配置retries參數實現自動重試

- 設置max.in.flight.requests.per.connection=1保證順序重試

- Broker端持久化策略

- 消息追加寫入Commit Log文件

- 支持多副本機制(Replication)

- 采用ISR(In-Sync Replicas)同步副本列表

- 支持min.insync.replicas配置最低同步副本數

- 消費者端確認機制

- 啟用手動提交offset(enable.auto.commit=false)

- 處理完消息后調用commitSync()同步提交

- 配合事務機制保證精確一次處理

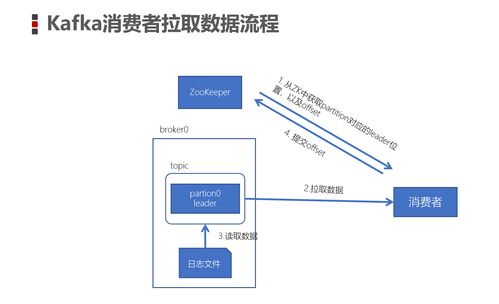

二、Kafka消費數據模式

- 消費者組模式(Consumer Group)

- 同一分組內消費者平均分配分區

- 支持水平擴展和負載均衡

- 實現"一個分區只被一個消費者消費"

- 獨立消費者模式

- 直接指定消費的分區

- 適用于特殊場景的定點消費

- 兩種訂閱方式

- 主題訂閱(subscribe):動態分區分配

- 分區分配(assign):靜態指定分區

三、Kafka的數據存儲形式

- 分區日志結構

- 每個分區對應一個物理文件夾

- 采用順序追加寫入方式

- 通過分段(Segment)機制管理文件

- 索引文件設計

- .index文件:存儲offset到物理位置的映射

- .timeindex文件:支持按時間戳查找

- 采用稀疏索引提升查詢效率

- 數據清理策略

- 基于時間的保留策略(log.retention.hours)

- 基于大小的保留策略(log.retention.bytes)

- 支持日志壓縮(Log Compaction)去除重復鍵

四、數據處理和存儲支持服務

- Connect框架

- 提供標準化數據導入導出接口

- 支持與關系數據庫、HDFS等系統集成

- 內置多種Connector實現

- Streams API

- 實現實時流處理功能

- 支持狀態管理、窗口操作

- 提供Exactly-Once語義保障

- 監控與管理工具

- Kafka Manager可視化管控平臺

- 內置Metric指標收集

- 支持JMX監控接口

- 集群協調服務

- 依賴ZooKeeper維護元數據

- 管理Broker注冊、主題配置

- 協調消費者組Rebalance操作

通過上述機制的協同工作,Kafka構建了一套完整的數據可靠性保障體系,在保證高性能的提供了企業級的數據持久化和處理能力。